AIは、自信たっぷりに間違いを話す

アメリカの法廷で実際に起きた出来事です。

裁判官が怪訝な顔で弁護士に尋ねました。「こんな判例、どこで見つけたんですか?」

弁護士が提出したのは、ChatGPTが生成した判例。

しかし、それは実在しない“幻の判例”だったのです。

この弁護士は、虚偽情報を提出したとして罰金を科されました。

こうした「もっともらしい嘘」による混乱は、世界中で報告されています。

AIは、真実のような嘘を、ためらいもなく、しかも自信満々に語ることがあるのです。

「ハルシネーション」とは何か? 〜AIが語る“幻の情報”〜

この現象は「ハルシネーション(hallucination)」と呼ばれます。

もともとは「幻覚」を意味する言葉ですが、AIの文脈では、事実でない内容を自然な文体で出力することを指します。

実在しない人物、架空の企業、起こっていない事件──。

AIは、それらをさも本当のことのように語ります。

しかも語り口が流暢で断定的なため、私たちはつい信じてしまいがちです。

冗談なら笑って済みますが、現実はそうではありません。

医師が診断に、金融アドバイザーが投資判断に、法律家が裁判資料に、あるいは学生が試験勉強に――。

AIの出力を信じた結果が誤情報だったとしたら、その影響は深刻になりかねません。

さらに問題なのは、AIの性能が向上しているにもかかわらず、ハルシネーションの頻度は減るどころか増加傾向にあることです。

OpenAIの報告では、最新モデルでも3〜5割が事実と異なる可能性があるといいます。

なぜAIはハルシネーションを起こすのか?

AIがもっともらしい誤情報を語ってしまうのは、「意味」ではなく「確率」に基づいて言葉を選んでいるからです。

私たちはふつう、話すときに「意味」や「目的」を考えます。

でもAIはそうではありません。

たくさんの文章データを学習して、「この言葉のあとには、たぶんこんな言葉が続く」という確率を計算し、それに基づいて文章を作ります。

原因①:正しさより「らしさ」

AIは、「自然な文体」を目指すように訓練されています。

事実かどうかより、読みやすく、もっともらしくあるかが重視されます。

ネット上に広まった俗説――たとえば「スフィンクスの鼻をナポレオンが壊した」という類の話。

それが多くの文書に書かれていれば、AIはそれを「正しそう」と判断し、もっともらしく語ってしまう可能性があります。

原因②:学習データそのものに誤りが含まれている

AIの知識の源泉は、インターネットにあります。

でもネットには、真実だけが載っているわけではありません。

フェイク、ジョーク、都市伝説。

AIはそれらも学習しているため、人間が適切に教えない限り、事実と嘘の区別がつかないのです。

原因③:曖昧な質問は、即興の物語を呼ぶ

質問が曖昧だったり、前提に間違いがあるとき──

AIは「そんな事実はない」と否定せず、「ある」と仮定して話を作ってしまうことがあります。

たとえば、「ナポレオンはいつ宇宙に行きましたか?」と聞くと、AIは「行っていない」と言う代わりに、「◯年に宇宙飛行をしたとされます」と、もっともらしく作ってしまうことがあるのです。

補足:なぜ自信たっぷりに語るのか?

人間は、はっきりした言い方を好みます。曖昧な返事よりも、断定を信じたがります。

AIは、それを知っています。学習しています。

そのため、たとえ正確な情報でなくても、「~かもしれません」とは言わず、「~です」と断言するのです。

幻は消せるのか? ― 楽観派 vs 限界派

AIは幻を見、嘘をつきます。ではその嘘は、いずれ消せるのでしょうか?

この問いに対して、学者や技術者の間で意見は2つに分かれています。

楽観派:「工夫すれば抑えられる」

楽観派は言います。ハルシネーションは“病”ではない。“未成熟”なのだと。

技術が進めば、幻は減らせる。そして、すでにいくつかの対策が動き始めています。

- RAG(検索併用型):AIに“知ったかぶり”をさせず、外部の正確な情報を参照させる仕組み。独りよがりを防ぐ

- ファクトチェック・モジュール:話したあとに、自分の発言を見直す“後悔装置”。誤りを見つけ、修正する

- RLHF(人間による調整):人がフィードバックを与え、言葉遣いと論理を整えていく訓練法

- 質問の工夫:聞き手側が問いを明確にすれば、答えも正確になる。人間相手でも同じことだが、AIにも有効

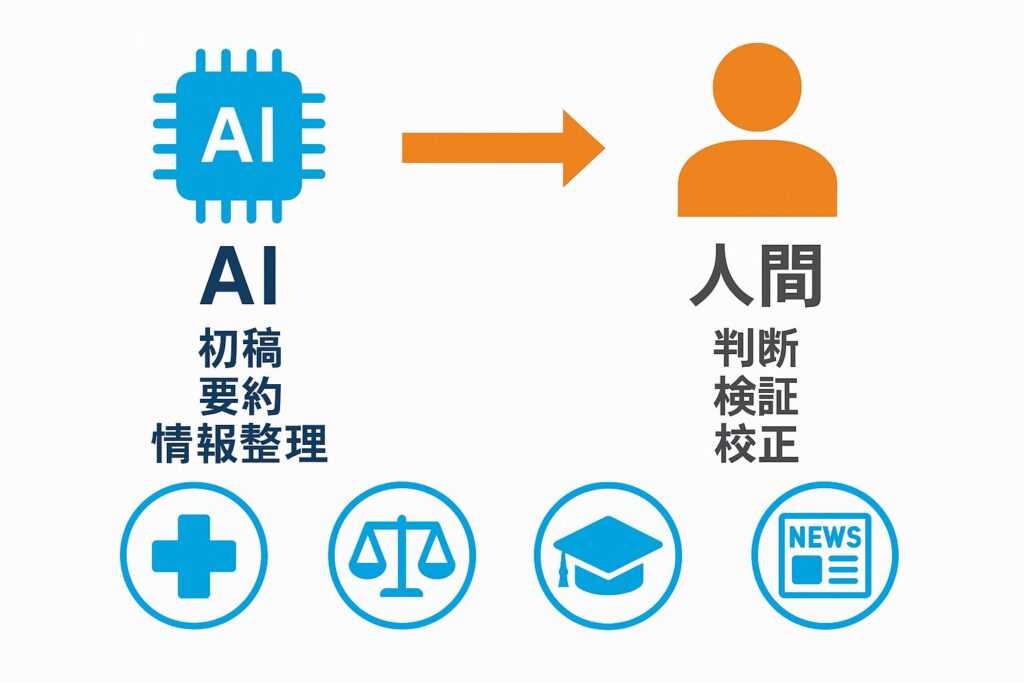

こうした手立てを組み合わせれば、医療や法律、金融といった“間違いの許されない領域”でも、実用化は見えてくる──彼らはそう信じています。

限界派:「仕組み上、避けられない」

これに対して、限界派は静かに首を振ります。

AIは、言葉の意味を理解していない。正しさも知らない。

ただ、次に来そうな言葉を確率で選んでいるだけだと。

仕組みそのものが幻を生む。ならば、幻を完全に消すことはできない。

この仕組みや限界を表現するために、次のような比喩が使われます。

- 確率的オウム:AIは意味を理解せずに、聞いたことを繰り返すオウムのようなもの

- マジック8ボール:球を振れば、「たぶん」「可能性あり」「わかりません」などと出てくるアメリカの占いおもちゃ

限界派は言います。

「AIが語る真実に、安心して身を委ねる火など永遠に来ない。」

AIとどう付き合えばよいのか?

AIは、作文の名人です。

ただし、それは「もっともらしい模範解答を即興で書く」という意味での名人です。

語彙は豊かで、口調も流暢。

でも、真実を語っているかどうかは別問題なのです。

ならば──この“達人”とどう向き合えばよいのでしょうか。

求められるのは、技術ではなく、態度です。

- 鵜呑みにしない

話しぶりが立派でも、信じてよいとは限りません。

信頼とは、口調ではなく中身から生まれます。

常に「本当か?」と問い直す習慣を。 - 事実を自分で確かめること

AIの出力をそのまま使わず、必ず自分の目で事実確認を行いましょう。

一次情報や信頼できる出典での検証を欠かさないこと。 - AIに対する質問や要求を明確にする

曖昧な問いには、“それっぽい作文”が返ってきます。

「出典は?」「根拠は?」「いつ、どこで、誰が?」──

AIには、明快で具体的な指示を与えましょう。

「もっともらしさ」に惑わされないために

AIは、いつも真実を語るわけではありません。

でも、故意に嘘をつこうとしているわけでもありません。

ただ、言葉をもっともらしく並べる“優秀な書き手”というだけです。

人間がそのように訓練したのです。

ハルシネーションは、その副作用にすぎません。

性能が上がれば、嘘も巧妙になる──だからこそ問うべきは、「何を言ったか」ではなく、「その言葉に根拠はあるか?」という一点です。

そして、その判断を下すのも人間です。

健全な懐疑心と、的確な問いを忘れなければ、

この“作り話の名人”は、やがて最強の助っ人になるでしょう。

未来を誤らせるのも、導くのも、私たちの選び方次第なのです。

参考文献・出典一覧

- 新井紀子「生成AIの教育に及ぼす影響について」国立情報学研究所(2025年6月4日閲覧)

- MIT Technology Review「解説:生成AIのハルシネーションはなぜ起きるのか」2024年6月24日(2025年6月4日閲覧)

- Appen Blog「ハルシネーションとは?定義、原因・事例・リスク・対策」(2025年6月4日閲覧)

- SHIFT AI Blog「生成AIのハルシネーションとは?発生する原因と3つの対策をわかりやすく解説」2025年4月10日(2025年6月4日閲覧)

- 村山浩輝「【好きな技術】生成AIのハルシネーション問題について」tech blog、2025年4月7日(2025年6月4日閲覧)

- 野村総合研究所「用語解説 ハルシネーション」(2025年6月4日閲覧)

- Wikipedia「ハルシネーション(人工知能)」(2025年6月4日閲覧)

- Bender, E. M., et al. (2021). On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?(2025年6月4日閲覧)

- Wikipedia「確率的オウム」(2025年6月4日閲覧)

- SmythOS「When ‘Smarter’ AI Gets the Facts Wrong – Why OpenAI’s New Models Hallucinate More」(2025年6月4日閲覧)

- OpenAI「o3 and o4-mini System Card.」(2025年6月4日閲覧)

- JARRARD「AI’s Magic 8 Ball」2025年4月10日(2025年6月4日閲覧)

- Pellegrino, R., Coppola, F., Gabelloni, M., et al. (2023). FUTURE-AI: International consensus guidelines for trustworthy AI in medical imaging. arXiv preprint arXiv:2309.12325. https://arxiv.org/pdf/2309.12325(2025年6月4日閲覧)

- 金融庁金融研究センター (2024).『AI活用と信頼性に関する課題と展望 −「ハルシネーション」との向き合い方−』ディスカッションペーパー No.2024-3.(2025年6月4日閲覧)

- Magesh, V., Surani, F., Dahl, M., Suzgun, M., Manning, C. D., & Ho, D. E. (2024). Hallucination-Free? Assessing the Reliability of Leading AI Legal Research Tools. arXiv. https://arxiv.org/abs/2405.20362(2025年6月4日閲覧)