なぜAIは、こんなにも急速に進歩したのか?

数年前まで、「AI」と聞いてワクワクした人は、そう多くなかったことでしょう。

翻訳はたどたどしく、質問に対する答えもどこかピントがずれていました。

現場で使える技術とは思えず、「どうせ人間の手で直さなきゃならない」と敬遠されていたものです。

でも、状況はあっという間に変わりました。

今のAIは、文章をすらすら書き、翻訳も自然です。

問いかければ、即座に答えが返ってきます。しかも、まるで人間のように。

PCやスマホの中で、いつの間にか頼れる“相棒”のようになっています。

一体、AIに何が起きたのでしょうか。

実はその進化は、突然の奇跡ではなく、水面下で地道に積み重ねられてきた技術の成果なのです。

本記事では、AIがここまで飛躍した背景を、3つの技術的転機と、それを支えた3つの環境変化から読み解いていきます。

転機①(2012年):「見る力」を手に入れたAI

現在のAIの礎となる進化は、意外にも画像認識の分野から始まりました。

かつてのAIは、画像の中から自分で特徴を見つけることができませんでした。

たとえば、「猫の耳はとがっている」とか、「バイクにはタイヤがある」といった情報を事細かに与えなければ、猫とバイクを見分けることすらできなかったのです。

これには大変な手間もかかりました。

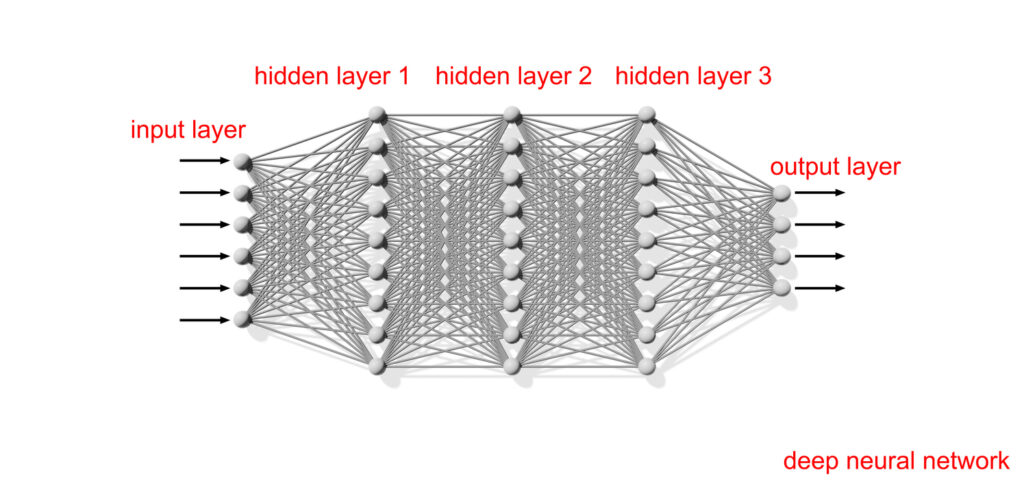

それを大きく変えたのが「ディープラーニング(深層学習)」と呼ばれる学習手法です。

これは、人の脳のはたらきをまねた「ニューラルネットワーク」という仕組みを使って、AIが情報を何段階にも分けて処理し、自分でパターンを学ぶ方法です。

この技術が注目されたのは2012年。

カナダ・トロント大学のジェフリー・ヒントンらのチームが開発した「AlexNet」が、1000万枚超の画像データから、猫やバイクを正確に分類することに成功しました。

注目すべきは、AIに「どこを見れば猫らしいか」を、いちいち教えなくてもよくなった点です。

何度も画像を見比べる中に、AI自身が判断に必要な特徴を学べるようになったのです。

この成果が、AIが「自分の目で世界を認識する」転機となりました。

また、学習速度が飛躍的に向上する効果をもたらしました。

転機②(2017年):「文脈」を読むAIの誕生

次にAIが進化したのは、言葉のつながりを捉える力においてです。

従来のAIは文章を1語ずつ順番に処理していました。

たとえるなら、真ん中に小さな穴が空いただけの目隠しをして世界を見ようとするようなもの。

視野が極端に狭いため、文章の全体像と言葉のつながりを正しくつかむことができませんでした。

この限界を打破したのが、2017年にGoogleの研究者が発表した「Transformer(トランスフォーマー)」という構造です。

その中核には、「Self-Attention(自己注意)」と呼ばれる革新的な技術があります。

Transformerは、文全体を一度に見渡しながら、「どの語がどの語と関係しているか」を把握します。

それは、視界が一気に開け、文章の”全体像”を俯瞰できるようになったのに等しい変化でした。

この仕組みにより、AIは「その人は駅で彼に会った」のような曖昧な文でも、前後の文脈からそれぞれ誰を指すのかを正確に推測できるようになりました。

つまり、Transformerの登場は、AIを単なる単語処理装置から、文脈を読むシステムへと変えたのです。

転機③(2018〜2020年):AIの「頭脳」が巨大化した

AIの能力を一気に“実感できる”ようになったのは、モデルの大規模化による性能向上です。

AIの「モデル」とは、学習したパターンや知識をもとに、判断や文章生成を行う「頭脳」にあたる部分。

その性能を左右するのが「パラメータ」と呼ばれる数値です。

これが多いほど細かな言語パターンを捉えられます。

たとえば、OpenAIが発表した「GPT-3(2020)」は1750億のパラメータを持ちます。

これにより、たった数行の指示から、驚くほど洗練された文章を返せるようになりました。

もっとも、パラメータを増やすことには副作用もあります。

誤った情報を、もっともらしく話してしまうリスク――いわゆる”ハルシネーション”がむしろ増えているのではないか、という指摘もあります。

それでも、文章としての自然さ、話し方の滑らかさという点において、モデルの巨大化が果たした役割は決定的でした。

第3の転機は、膨大なデータを読み込み、徹底的に訓練された結果として生じました。

特別な技術革新ではなく、物量戦の勝利です。

進化を加速させた「3つの追い風」

AIの進化は、ただ技術だけで起きたわけではありません。

筋トレにたとえるなら、器具も、栄養も、環境も、すべてがそろっていました。

- 計算力の向上

画像処理などに使われていたGPU(高性能チップ)が、AIの学習に理想的でした。

GoogleはさらにAI専用チップTPUを投入。

これにより、膨大な学習計算が短時間で可能になりました。

本格的な筋トレ器具をAIは一気に手に入れたのです。 - データの爆発的増加

ネット上には、ニュース記事、翻訳例、SNS投稿など、大量の言語データがあふれています。

AIにとってこれは、高タンパクの栄養食のようなもの。

食べれば食べるほど、言語のパターンを体得していきました。 - 資金の集中

ChatGPTの成功を見て、世界中の企業や投資家がAIに巨額の資金を投じました。

研究施設、人材、クラウド設備が次々と整備され、

まるで、最新マシンとプロトレーナーがそろったジムのような環境ができあがりました。

ここまで条件がそろえば、進化は自然な成り行きでした。

AIはひたすら鍛えられ、走り出します。

誰も止めることはできませんでしたし、これからも立ち止まることはないでしょう。

AIと賢く付き合うために

AIの飛躍は、奇跡ではありません。

3つの転機と、3つの追い風が、その歩みを後押ししました。

言葉のルールを覚え、文脈を読み、頭脳を巨大化させました。

そこに計算力、データ、資金という養分が注がれました。

そして今、AIは「道具」から「相棒」へと姿を変えつつあります。

次に待つのは、自ら考え、判断し、動くAI――エージェントの時代です。

そしてその先には、汎用人工知能(AGI)やシンギュラリティが見えてきます。

この技術はどこに向かうのでしょうか。

それを見極めるには、どこから来たのかを知る必要があります。

AIについても、それは例外ではないのです。

参考文献・出典一覧

- 一般社団法人 生成AI活用普及協会『生成AIパスポート 公式テキスト』

- IPA(情報処理推進機構)『AI白書2017』、2017年 PDFリンク

- Vaswani, A. et al.『Attention Is All You Need』、arXiv、2017年 論文リンク

- Kaplan, J. et al.『Scaling Laws for Neural Language Models』、arXiv、2020年 論文リンク

-

Wikipedia

ディープラーニング(2025年6月2日閲覧) -

Wikipedia

ジェフリー・ヒントン(2025年6月2日閲覧) -

Wikipedia

ImageNet(2025年6月2日閲覧) -

Wikipedia

Transformer(機械学習モデル)(2025年6月2日閲覧) -

AI Market

Transformerとは?何がすごい?仕組み、特徴、ChatGPTのベースにもなったディープラーニングモデルを詳しく解説(2025年6月2日閲覧) -

Big Data Analytics News

Exploring the Architecture of Large Language Models(2025年6月2日閲覧) -

Google Cloud Blog

GPU と TPU を使用して、高パフォーマンスで費用対効果の高い大規模な AI 推論の実現をサポート(2025年6月2日閲覧) -

Investor’s Business Daily

How CoreWeave Plans To Rule The AI Cloud With Nvidia In Its Corner(2025年6月2日閲覧) -

Crunchbase News

Startup Funding Regained Its Footing In 2024 As AI Became The Star Of The Show(2025年6月2日閲覧) -

The Wall Street Journal

Cathay Innovation Reloads With a $1 Billion AI-Focused Venture Fund(2025年6月2日閲覧)